Производители ноутбуков по циклу обновления своих устройств фактически привязаны к разработчикам комплектующих, а у тех он составляет примерно один год. В данном случае речь идет об NVIDIA, графические решения которой в текущий момент используются в 15-дюймовом Retina MacBook Pro и в iMac. В общем-то, производительности хватает, если не говорить об играх и лэптопе, который начинает весьма ощутимо греться, да и максимальное разрешение дисплея для мобильного GPU великовато, особенно в последних играх. Но, вполне возможно, что проблема нагрева и производительности будет решена с релизом следующего поколения Retina MacBook Pro, построенного на базе видеокарты из серии GeForce GT 700M.

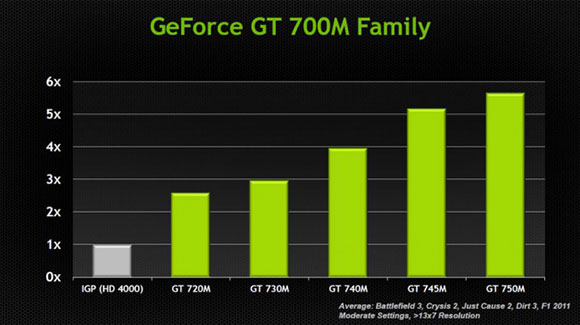

Всего в линейке пять GPU из которых пара начального уровня — 720M и 735M, остальные же считаются производительными игровыми решениями — это 740M, 745M и 750M. Если сравнивать производительность видеокарт со встроенным решением Intel HD4000, которое установлено во всех MacBook Pro (в 15-дюймовом как дополнительный GPU), в MacBook Air и в Retina MacBook Pro (в 15-дюймовом тоже является вторым видеочипом), то даже самый бюджетный вариант в 2,5 раза быстрее. Хотелось бы увидеть в будущем 13-дюймовом Retina MacBook Pro хоть такое решение, так как возможностей встроенной видеокарты явно не хватает.

Основная же фишка серии GeForce GT 700M, построенной на базе архитектуры Kepler, заключается не в лютой мощи, а в эффективной работе системы, когда оптимальная производительность достигается за счет минимального энергопотребления и нагрева. Технология получила название GPU Boost 2.0 и заключается в динамическом изменении частоты ядра в зависимости от нагрузки и температурного режима. То есть, видеокарта будет пытаться выдать максимальную мощность при активной игре, но можно не опасаться графических артефактов, возникающих из-за перегрева, который GPU Boost 2.0 теоретически не допустит.

Естественно, при работе в щадящем режиме, когда обрабатывается лишь интерфейс ОС, энергопотребление будет снижено до минимального уровня, что положительно скажется автономности ноутбука. Ах да, есть ведь еще технология NVIDIA Optimus, позволяющая автоматически переключаться на экономичный встроенный GPU от Intel, но, как показывает практика, из-за высокого разрешения дисплея в Retina MacBook Pro 15" практически все время работает GeForce. Так что снижение его энергопотребления в этом случае очень актуально.

Рассмотренные выше чипы уже доступны всем желающим, соответственно, ждем волны обновлений со стороны всех крупных игроков ноутбучного рынка, включая Apple. [NVIDIA]

Ну вот сразу с процом и обновят.