Во многих материалах на нашем и других сайтах, на официальной странице Apple и прочих ресурсах то и дело упоминаются машинное обучение и искусственный интеллект.

Тем не менее, подавляющее большинство читателей не осознают особенности этих терминов и либо приписывают им мистические свойства, либо просто пропускают мимо.

Чтобы расставить все на свои места, мы решили провести масштабный ликбез, который должен ответить на ключевые вопросы и, надеемся, не вызовет большого количества дополнительных.

Мы только ждем бум искусственного интеллекта

Большинство называет искусственный интеллект будущим, многие сравнивают ИИ с научной фантастикой, а некоторые даже считают его полноценной частью нашей жизни.

Каждое из этих утверждений верно по-своему. В данном случае все зависит только от точки зрения. Нужно просто объяснить самому себе, что же вообще такое этот искусственный интеллект.

Некоторое время тому назад компьютерная программа Google DeepMind AlphaGo обыграла профессионала Ли Седола из Южной Кореи в азиатскую стратегическую настолку го.

А до этого аналогичные программы уже обходили профессиональных игроков в шахматы. Для этого они анализировали все возможные ходы и выбирали наиболее удачные.

Работы подобного софта стала возможной благодаря искусственному интеллекту, машинному и глубокому обучению. Второе понятие в данном случае — часть первого, а третье — часть второго.

Машинное обучение — часть искусственного интеллекта. А глубокое обучение — часть машинного.

Впервые об искусственном интеллекте заговорили на Дартмутских конференциях в 1956 году. Именно середину прошлого века принято считать временем рождения этого направления.

С того времени ИИ считали далеким будущим человечества, которое многие считали достаточно светлым, а некоторые — началом конца нашего рода по сценарию Терминатора.

D 2012-2017 годах случился переворот в понимании искусственного интеллекта, причиной которого оказался рост производительности современных вычислительных систем.

Кроме увеличения скорости работы современных процессоров на развитие ИИ повлияло распространение баз со снимками и другим контентом. Но обо всем по порядку.

Искусственный интеллект, который подражает нашему

Подражание человеку на базе ИИ

В середине прошлого века энтузиасты считали, что для создания искусственного интеллекта необходимо создать железную копию человеческого организма.

Копия должна обладать аналогами наших органов чувств и даже рассудком — примерно эта концепция обыгрывается и в фильме Бегущий по лезвию 2049.

Репликантов можно убивать. Они холодны и бессердечно жестоки. Они неспособны к эмпатии — это именно то, на чём их ловит тест — им всё равно. (Грегг Рикман, 1981)

Этот подход до сегодняшнего дня так и остался только лишь в фильмах. До создания копий людей технологии так быстро не дошли. Думаю, это к лучшему.

Тем не менее, нам уже под силу создать технологии, которые будут выполнять не все человеческие функции, но хотя бы их часть. И делать это более качественно, чем люди.

По этому принципу работает сортировка снимков по изображенных на них людях в фотографиях, которую активно использует Apple, или классификация картинок по содержанию в Pinterest.

Существование описанных выше технологий стало возможным благодаря использованию, так называемого, машинного обучения, которое и дало толчок развития ИИ.

В машинном обучении используются алгоритмы обработки и анализа данных, после чего происходит принятие того или иного решения — совершение наиболее оптимального выбора.

С помощью машинного обучения программное обеспечение не заставляют выполнять задачу по конкретному принципу, но учиться делать это самостоятельно.

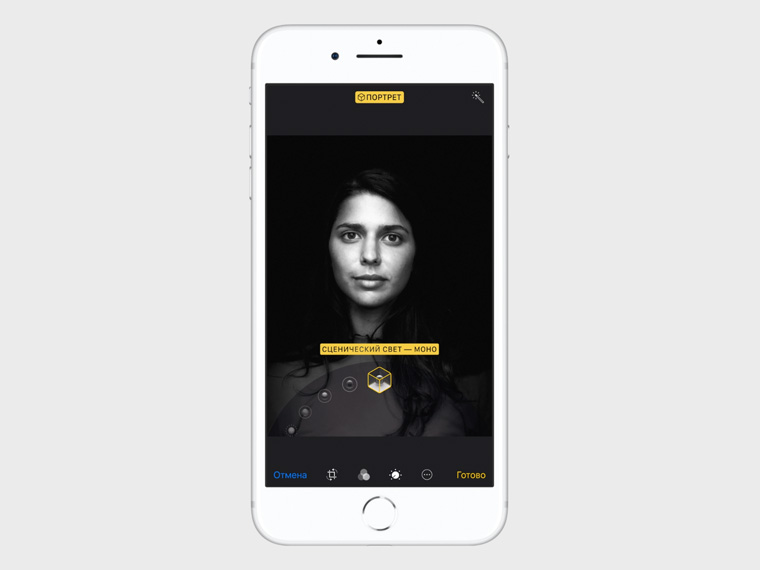

Именно с помощью него Apple добилась правильной работы портретного режима, который появился в iOS 10, и совершенствует портретное освещение из iOS 11.

Машинное обучение оказалось ключом к развитию ИИ

Режимы съемки, основанные на машинном обучении

Именно машинное обучение оказалось главным толчком к развитию того, что сегодня принято называть искусственным интеллектом — по крайней мере, сегодня считают именно так.

Когда человек только рождается, он не знает об окружающем мире ровным счетом ничего. Он не умеет просто ходить — речь в данном случае не идет даже об общении с себеподобными.

Но он активно учится и поглощает всю получаемую с самых разных сторон информацию не худе какой-нибудь губки. Впитывает, пропускает через себя и становится умнее.

Постепенно человек учится самым невероятным вещам. Он садится за руль автомобиля и не врезается в другие машины в потоке, лихо крутит педали двухколесного велосипеда и даже не падает.

За десятки лет специалисты в отрасли искусственного интеллекта пришли к выводу, что создать подобие нашего разума даже для выполнения узкой задачи невозможно.

Тем не менее, можно разработать программу, которая будет обучаться. Тогда с течением времени она будет становиться все более полезной.

Возникает еще один вопрос — проблема со скоростью обучения. Каким образом сделать так, чтобы программа становилась умнее не за годы, а за месяцы.

Ее актуальность закономерна. Человечество развивается настолько интенсивно, что даже через пару лет в какой-то технологии не будет никакого смысла — о десятках даже речи не идет.

И наиболее эффективное решение в данном случае в 2017 году становится основным конкурентным преимуществом на мировой арене — по крайней мере, в пользовательской электронике точно.

Как работают нейронные сети и глубокое обучение

Современная производительность, которая открыла путь к развитию нейронных сетей

Ответом на поставленный чуть выше вопрос оказалось алгоритмическое решение, которое в итоге назвали нейронными сетями.

Они основаны на наших биологических знаниях о строении человеческого мозга и связях между его отдельными нейронами — только в дискретном пространстве.

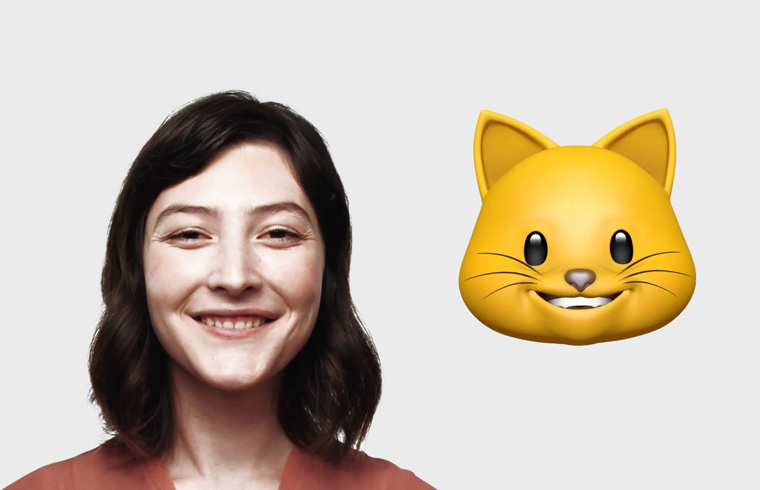

С помощью этой системы можно взять, например, фотографию кота, разрезать ее на отдельные части и отправить по уровням сети. Потом повторить тоже самое с еще одной и так далее.

Аналогичный принцип для теста собственного нейронного механизма использовала компания Google, которой удалось натренировать системы отбирать видео с кошками в YouTube.

Каждый нейрон в сети в данном случае анализирует полученные данные и сравнивает с заученными аналогами, которые были скормлены ему ранее.

Чем больше сходство, тем выше вероятность того, что в кадре действительно присутствует кот. А в сумме нейронная сеть может дать ответ на этот вопрос с большой точностью.

До относительно недавнего времени нейтронные сети просто игнорировались. Они были вполне реальными еще в прошлом веке, но толку от них было не так много.

А все потому, что еще несколько лет тому назад производительные системы, которые могли бы работать в нейронными сетями, были крайне дорогими. А данные в необходимом числе недоступными.

Но в итоге ученые смогли расширить нейронными сети до невероятных размеров, сделали приемлемой скорость работы и скормили им тонны контента. Так появилось глубокое обучение.

Будущее Apple зависит именно от нейронных сетей

Безграничность новых технологий, основанных на ИИ

Возвращаемся к компании Apple, которую продолжают ругать за отсутствие инноваций. И делаем далеко не самый очевидный вывод — а ругают-то производителя зря.

А все дело в том, что будущее пользовательской электроники сегодня зависит отменно от ИИ, который сегодня ассоциирует с понятием нейронный сетей.

Подавляющее большинство действительно интересных технологий, которыми мы пользуемся завязано именно на нейронных сетях — с этим невозможно спорить.

Мы уже говорили о портретном режиме с его новым модным освещением, сортировке фотографий в галерее и так далее. Но это только начало.

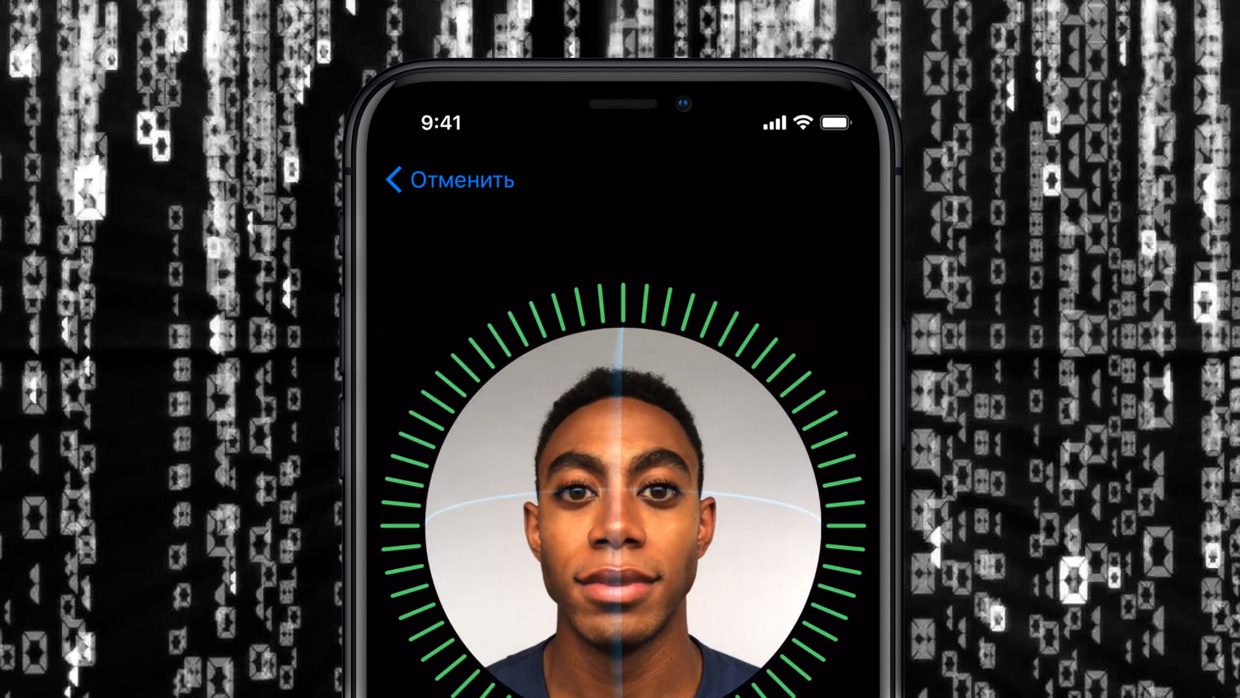

Технология распознавания лиц в Face ID тоже базируется именно на этом принципе. Конечно, технологии прямиком из Kinect, который когда-то разрабатывала Microsoft тоже в теме, но они — не все.

Если бы Apple не научила сканер лица отличать настоящих людей от фото и макетов, грош цена была бы всей затее отказываться от привычного нам отпечатка пальцев Touch ID.

И аналогичная ситуация с изменениями нашей внешности во времени — то борода отрастет во все лицо, то очки перед разблокировкой не снимешь или челку со лба не уберешь.

Все эти изменения искусственный интеллект обрабатывает на основании нейронных сетей, который продолжают учить, скармливая ему миллионы фотографий.

И на ИИ ставят не только в Apple. Многие технологии новых Google Pixel также завязаны на нейронных сетях — даже портретный режим с помощью одной камеры. Нет сомнений — все это только начало.

По-моему, Apple стоило бы постыдиться упоминать о машинном обучении и искусственном интеллекте! Мало того, что их ассистент Siri был рожден умственно отсталым, так за несколько лет он не научился ничему. Siri находится на уровне “Голосового управления” от iPod, только ему для этого еще и в интернет лазить нужно. Почему их нельзя хотя бы совместить? Когда Siri сможет ставить таймер, говорить время или переключать трэк, если нет сигнала? Или звонить… весело читать истории как Siri кому-то спасла жизнь в ЧС. А на природе чаще есть сигнал для звонка, но нет мобильного интернета, и ЧС на природе тоже чаще бывают. Где истории про то, как Siri шлет пользователей нах вместо того, чтобы звонить в службу спасения? Никто не выжил, чтобы их рассказать?))