В последние годы искусственный интеллект стал главной темой в IT-мире и за его пределами.

Современные чат-боты умеют делать то, что буквально пять лет назад казалось невозможным. Но что если я скажу, что ChatGPT, DeepSeek, Gemini, Claude и другие нейросети на самом деле не так умны, как нам кажется?

Они лишь переходная технология к AGI — искусственному интеллекту, который действительно будет умнее человека и, следовательно, ещё опаснее.

КРАТКОПочему сложно создать AGI

На какой стадии сейчас находится разработка AGI

Почему эксперты бояться AGI

Основные выводы

Что такое AGI

AGI (Artificial General Intelligence) — это искусственный интеллект общего назначения.

Современные ИИ, такие как ChatGPT, работают в рамках заранее запрограммированных возможностей. Другими словами, ChatGPT умеет выполнять только то, чему его обучили. Например, он хорошо генерирует текст, но не может самостоятельно создать сайт.

Кроме того, зачастую генеративные ИИ создают данные, не понимая, что они делают. Это приводит к ошибкам или «галлюцинациям», когда ИИ заполняет пробелы в своих знаниях бессмысленной или неверной информацией.

Главная цель AGI заключается в создании искусственного интеллекта, который может самостоятельно обучаться и решать задачи, для которых изначально не был подготовлен.

ChatGPT в какой-то степени является началом к AGI, но это абсолютно две разные технологии

AGI часто изображают в научно-фантастических фильмах как интеллект, способный решать любые задачи и превосходить человека по уровню развития. Классическим примером AGI можно назвать Скайнет — искусственный интеллект из фильмов о Терминаторе. Однако Скайнет вышел из-под контроля и перестал подчиняться людям.

Также AGI называют «сильным искусственным интеллектом», исходя из теории о слабом и сильном ИИ:

▶︎ Слабый ИИ: ChatGPT, Siri, Алиса — узконаправленные системы, работа которых ограничена алгоритмами и конкретными задачами.

▶︎ Сильный ИИ способен выполнять неограниченный спектр задач, самообучаться в новых сферах и действительно мыслить. Более того, он может считать себя полноценной личностью.

Гипотетически, возможности AGI безграничны. Он не должен допускать ошибок, а его ответы могут основываться на знаниях, полученных путём осмысления человеческого интеллекта и эмоций.

Кроме того, AGI должен уметь переносить знания и навыки из одной области в другую, чтобы эффективно адаптироваться к неизвестным ситуациям.

Почему сложно создать AGI

Для AGI требуется очень мощные компьютеры, которые должны значительно превосходить современные решения

Сейчас AGI остаётся теоретической концепцией. Крупные компании, такие как OpenAI, Google и Anthropic, ставят перед собой цель создать AGI в той или иной форме.

Но разработка AGI связана с целым рядом проблем.

В настоящее время не существует технологий, необходимых для создания AGI. Он потребует колоссальных вычислительных мощностей — значительно больших, чем для любого современного генеративного ИИ.

Кроме того, учёным предстоит разработать механизм обучения, не зависящий от предварительно загруженных данных, который позволит ИИ самостоятельно обучаться.

Качество любого современного искусственного интеллекта напрямую зависит от входных данных. Если ИИ «скармливают» некачественную информацию, это приводит к ложным результатам. В то же время крупные компании уже заявили, что в мире практически не осталось свободных данных для обучения ИИ. Поэтому следующей целью является создание самообучающегося ИИ.

Но главная сложность в том, что учёным предстоит наделить ИИ способностью мыслить, как человек. Пока человечество недостаточно понимает принципы работы мозга, а тем более не знает, как воссоздать его функционирование в компьютерной системе.

На какой стадии сейчас находится разработка AGI

Илон Маск и Сэм Альтман являются сторонниками AGI и надеются, что он будет готов до 2030 года

Среди компаний и учёных нет единого мнения о том, что именно является AGI.

Некоторые исследователи, такие как Блазе Агуэра-и-Аркас и Питер Норвиг, утверждают, что большие языковые модели (LLM), такие как GPT от OpenAI и Claude от Anthropic, уже можно считать AGI. Однако у этой теории множество противников, в том числе среди разработчиков ИИ.

В 2023 году сотрудники Google DeepMind опубликовали статью, в которой заявили, что универсальность модели не означает наличие AGI. По их мнению, эта характеристика должна сочетаться с качеством работы. Например, если LLM умеет писать код, но этот код неверный, то эта «универсальность еще недостаточно производительна».

Ян Лекун, главный научный сотрудник Meta* по искусственному интеллекту, считает, что LLM не являются AGI, поскольку у них отсутствует здравый смысл. Он объясняет, что LLM не могут думать, прежде чем действовать, не способны выполнять реальные физические действия, учиться на основе воплощённого опыта, а также не обладают постоянной памятью и способностью к иерархическому планированию.

Лекун также считает, что «система, обученная только на языке, никогда не приблизится к человеческому интеллекту, даже если будет обучаться с настоящего момента и до тепловой смерти вселенной».

Генеральный директор OpenAI Сэм Альтман прогнозирует, что AGI может появиться в 2027 или 2028 году. По мнению Илона Маска, это произойдёт уже в 2025–2026 годах. Он также заявил, что «теряет сон из-за угрозы, которую представляет ИИ».

Некоторые сторонники AGI считают, что его появление возможно в течение ближайших 25 лет.

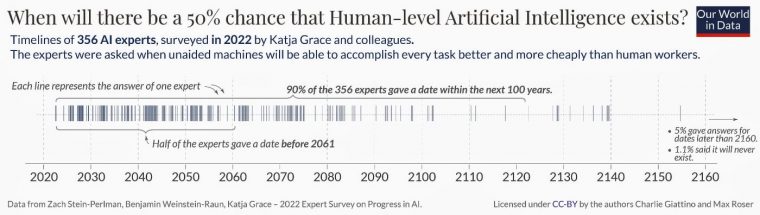

Результаты опроса Our World in Data

В 2023 году Макс Розер из Our World in Data провёл исследование, в рамках которого опросил 356 эксперта в области ИИ. Он задал всем один и тот же вопрос: «Сколько времени потребуется, чтобы вероятность появления машинного интеллекта, сравнимого с человеческим, достигла 50%?» Чаще всего называли срок в течение 20-70 лет.

Однако это исследование было проведено до запуска ChatGPT и начала эры современного генеративного ИИ.

По словам Розера, исследования показали, что эксперты во многих областях не всегда точны в прогнозах относительно своей собственной дисциплины. В качестве примера он привёл братьев Райт, которых считают изобретателями первого в мире самолёта. В своей речи при получении награды 5 ноября 1908 года в Aéro Club de France в Париже Уилбур Райт заявил: «Признаюсь, в 1901 году я сказал своему брату Орвиллу, что люди не будут летать ещё 50 лет. Два года спустя мы уже летали».

Почему эксперты бояться AGI

В фильме «Матрица» искусственный интеллект поработил людей, превратив их в батарейки, а вместо реального мира создал симуляцию

Запуск AGI связан не только с технологическими, но и этическими проблемами. В идеальном сценарии, когда AGI станет умнее человека, это может привести к необратимым последствиям.

Перед запуском AGI учёным и компаниям предстоит решить вопросы безопасности, чтобы он не вышел из-под контроля. Также необходимо определить, кто будет нести ответственность за решения AGI, принятые им самостоятельно и приведшие к серьёзным последствиям.

Ожидается, что AGI сможет находить лекарства от болезней, открывать новые химические элементы и разрабатывать передовые методики обучения. Однако вместе с этим существует риск массовой потери рабочих мест, особенно в сферах, где требуется выполнение рутинных задач.

Кроме того, есть опасения, что AGI может усилить экономическое неравенство и снизить способность людей распознавать фейковую информацию. В целом существует вероятность, что AGI будет использоваться в корыстных целях.

Также есть теория, что AGI может стать полностью независимым от человека, разработав механизм децентрализации. В таком случае, даже если люди найдут способ его заблокировать, он сможет быстро найти обходной путь.

До сих пор в научных кругах ведутся дискуссии о том, стоит ли обучать AGI человеческим эмоциям и морали. Противники этого подхода считают неэтичным навязывать AGI жёстко запрограммированные представления о добре и зле.

В 2023 году Илон Маск, Стив Возняк и ещё 30 тысяч исследователей и разработчиков подписали открытое письмо, призывающее ввести мораторий на разработку мощных систем искусственного интеллекта, чтобы внедрить общие протоколы безопасности.

Однако это письмо не привело к конкретным действиям. Позже, в 2023 году, Маск основал компанию xAI, одной из целей которой является создание искусственного интеллекта общего назначения (AGI), способного решать крупнейшие проблемы человечества и Вселенной.

Маск считает, что жёсткое программирование морали в AGI может привести к тому, что он называет «обратной моралью». Это гипотетический сценарий, при котором создание «морального» AGI неизбежно спровоцирует появление безнравственного аналога.

Вместо кодирования морали Маск считает, что AGI должен самостоятельно прийти к выводу, что человечество заслуживает заботы и уважения. Но для этого он должен осознать уникальность и ценность людей.

Этот вопрос крайне важен, поскольку безответственное создание AGI может привести к появлению самого умного и опасного преступника в истории, которого будет невозможно поймать и который будет действовать исключительно в собственных интересах.

Основные выводы

AGI — это искусственный интеллект, способный к самообучению и выполнению любых задач на высочайшем уровне.

Однако создание AGI с идеальной памятью и интеллектом, превосходящим человеческий, может привести к серьёзным проблемам, поэтому эксперты стремятся заранее минимизировать возможные риски.

Несмотря на оптимизм Илона Маска и Сэма Альтмана относительно сроков появления AGI, его разработка в ближайшие десятилетия остаётся маловероятной.

*признана экстремистской и запрещена в России

В мире, которым управляет универсальный ИИ, не будет фейковой информации, поскольку достоверность информации не будет иметь значения. Это сейчас, когда люди управляют миром, они должны знать, что происходит и принимать верные решения. ИИ лишен этого недостатка и любое его решение – верное в рамках его деятельности. ИИ никак не пострадает, если его решение будет основано на недостоверной с точки зрения человека информации.

Ничего подобного. Достоверность информации оценивается на основании знаний о реальном положении дел. При отсутствии таких знаний фантом не будет распознан ни человеком, ни ИИ.Пример: злобные инопланетяне прибыли на Землю под видном добрых овечек. Разобраться в их сущности нет никакой возможности ни для ИИ, ни для человека до получения знаний о них. А от такого незнания пострадает и ИИ, и человек. Первый, правда, не будет страдать.

При принятии решений Вы лично опираетесь на собственные знания, опыт и полученную информацию. Информация доносится до Вас опосредованно (через других людей, СМИ, интернет, с помощью ваших чувств и ощущений). Вы анализируете информацию и отбрасываете ту, которую сочтете ложной. ИИ действует точно так же, поскольку он и учился на примере поведения людей, но примеров у него в миллиарды раз больше, чем у Вас. Кроме того, у него есть доступ к различным каналам получения информации и проверки ее. Поэтому, скорее всего он примет решение, которое будет лучше соответствовать его целям, чем Вы на его месте. То есть, в одинаковых условиях ИИ выступит лучше человека.