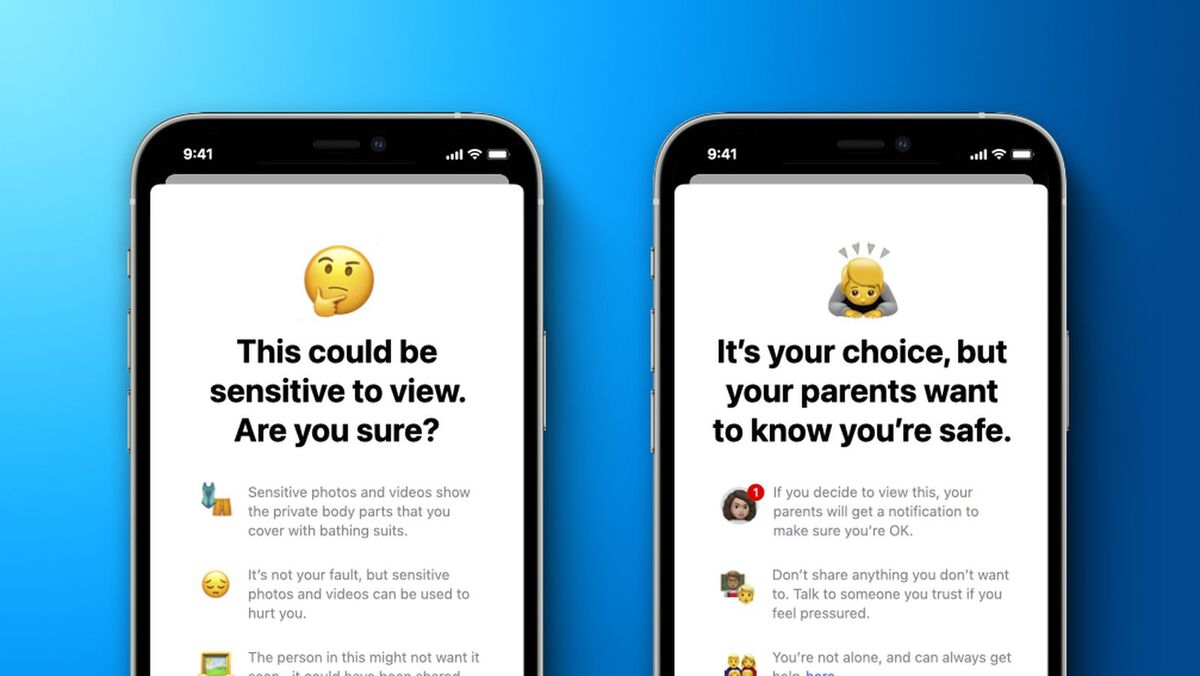

Издание Reuters опубликовало комментарии некоторых сотрудников Apple по поводу внедрения функции CSAM в iOS 15. Информация была получена из рабочего чата в Slack, участники попросили не раскрывать своих имён.

Как оказалось, многие обеспокоены тем, что авторитарные государства могут в будущем заставить техно-компании использовать похожие алгоритмы для выявления «неугодных» лиц на фото.

Один из сотрудников сказал, что с прошлой недели, когда было объявлено о внедрении алгоритма, в Apple уже поступило более 800 сообщений об обнаружении фотографий, которые содержат жестокое обращение с детьми.

Однако часть опрошенных выражают поддержку в адрес этой функции, считая, что она действительно способна помочь в борьбе с распространением «незаконных материалов». [9to5Mac]

Войди и оставь комментарий

Или войди с помощью

Последнее время у всех пердаки подогрелись на фоне этой новости, чую когда кого-то схватят то у всех пердаки просто полыхнут на всю ивановскую

Если есть что скрывать, то Вы должны пользоваться кнопочными телефонами. Они хотя бы открыто говорят.

@arman91, что мне делать с уже купленным ранее iphone 12pro? Пердак у меня не горит, просто неприемлю чужую рожу в моей спальне.

Данный алгоритм может быть использован для поиска любой вещи и любого человека.

@iBolobay, если-бы Вы потратили 5 минут на чтение других публикаций касательно этой темы, даже на этом сайте, Вы бы поняли, что – нет, не может.

Алгоритм не анализирует содержимое/смысл изображений, фотографии сделанные Вами будут обладать уникальными характеристиками, алгоритм работает только с уже существующими изображениями, изображениями которые были внесены в базу CSAM. Для избежания даже минимального ложноположительного срабатывания, применяется метод критической массы (То есть, даже если каким-то образом у фотографий будет очень похожий “код”, срабатывание произойдёт только если таких совпадений много).

@Phonerz, прикрываться детьми ради внедрения какой нибудь подлости это международный стандарт. Тут главное начать и убедить, что все будет ок. А дальше эта машина поедет без остановок.

@Phonerz, а вы не задумывались, что это просто первый шаг? Когда-то в США геев высмеивали в фильмах, и куда сейчас притопали. Вопрос не про детское насилие а про то, что это развязывает руки им копаться в фотографиях пользователей, хотя не сомневаюсь, что они уже давно это делают…

@Phonerz, а вот я открыл оригинальный документ от Apple и почитал. И да, допустим, что сейчас шанс ложного срабатывания ничтожен. Я даже уверен, что Apple это дело хорошо тестила.

Дело тут в другом, что для меня описанная система выглядит как на 100% готовая инфраструктура именно что для поиска любого изображения у любого человека. Если убрать отсюда бедных детей, которых государства каждый раз используют как щит, чтобы запустить свои ручищи в личную жизнь граждан, то что остаётся? А то, что сегодня там CSAM, а через год-два там база DAM (Democracy Abuse Material) для Штатов или CAM (Communism AM) для Китая. Потому что вопрос тут будет простой: “Дай нам загрузить свою базу или уходи с рынка”. И я знаю, что выберет Кук и Эппл

@AppleDominator, и iBolobay абсолютно прав. Он говорит не про текущую систему, а про “алгоритм”, и вот алгоритм имхо абсолютно универсален

@iBolobay, А вот сейчас неверно. С места ответил фигню спорол.

Ладно, пока это только в Асашай работает. А когда такая функция в нашей стране будет активна? Тут реально уж лучше на кнопочник переходить.

Господи – просто эти нехорошие элементы будут хранить фотографии в зашифрованном виде.. и никакой хешь сходиться не будет у них…

ну наверное совсем идиотов они первое время и поймают… это хорошо – но потом люди адаптируются.. поэтому не знаю на сколько это полезно будет на долгосрочном этапе – но при этом телефон будет делать дополнительную нагрузку.

А вот бороться с новым и широко распространяющимся контентом то контента вполне можно – включил в реестр. Кроме того власти в полне могут заставить эпл вкючать помимо этого реестра еще и свои государственные реестры. и в результате туда могут попадать все что угодно. Как говорят благими намереньями построена дорога в ад. Поэтому если педофилы например могут обманывать эту систему с легкостью то зачем ее внедрять?

Рекомендуем

Нашли орфографическую ошибку в новости?

Выделите ее мышью и нажмите Ctrl+Enter.